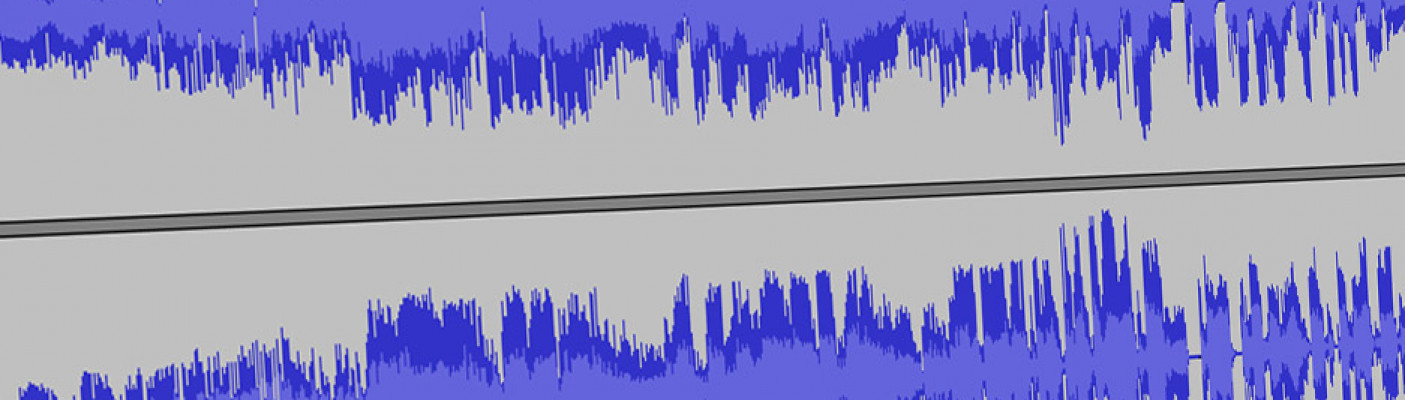

Zunächst funktionierte der Angriff nur über eine Datenschnittstelle, mittlerweile auch über Lautsprecher. Das ist komplizierter, da der Raum, in dem die Datei abgespielt wird, den Klang beeinflusst. Beim Erstellen der manipulierten Audiodateien berücksichtigte Lea Schönherr daher die sogenannte Raumimpulsantwort. Diese beschreibt, wie ein Raum den Schall reflektiert und den Klang verändert. Mit speziellen Computerprogrammen lässt sich die Raumimpulsantwort simulieren.

„Wir können den Angriff also für einen bestimmten Raum maßschneidern", berichtet die Kommunikationstechnikerin. „Kürzlich ist es uns aber sogar gelungen, einen allgemeinen Angriff durchzuführen, der keine Vorinformationen über den Raum benötigt, und trotzdem genauso gut oder sogar noch besser auf dem Luftweg funktioniert." Künftig plant die Wissenschaftlerin auch Tests mit auf dem Markt erhältlichen Sprachassistenten.

Da sprachgesteuerte Systeme aktuell nicht in sicherheitskritischen Bereichen im Einsatz sind, sondern lediglich dem Komfort dienen, können die Adversarial Examples derzeit keinen großen Schaden anrichten. Daher sei es noch früh genug, die Sicherheitslücke zu schließen, meinen die Bochumer Forscher. Im Exzellenzcluster Casa, kurz für Cyber Security in the Age of Large-Scale Adversaries, kooperiert die Arbeitsgruppe Kognitive Signalverarbeitung, die die Angriffe entwickelt hat, mit dem Lehrstuhl für Systemsicherheit von Prof. Dr. Thorsten Holz, dessen Team an Gegenmaßnahmen dazu arbeitet.

Der IT-Sicherheitsforscher Thorsten Eisenhofer will Kaldi beibringen, für Menschen nicht hörbare Bereiche in Audiosignalen auszusortieren und nur das zu hören, was übrig bleibt. „Wir können natürlich nicht verhindern, dass Angreifer Audiodateien manipulieren", sagt er. Sein Ziel ist es, dass die Manipulation aber in den für Menschen hörbaren Bereichen platziert werden müsste; so ließen sich die Angriffe nicht so leicht verstecken. Dafür nutzt Eisenhofer das MP3-Prinzip.

MP3-Dateien werden komprimiert, indem für Menschen nicht hörbare Bereiche gelöscht werden – genau das ist es, was die Verteidigungsstrategie gegen die Adversarial Examples auch vorsieht. Eisenhofer kombinierte Kaldi daher mit einem MP3-Encoder, der die Audiodateien zunächst bereinigt, bevor sie zum eigentlichen Spracherkenner gelangen. Die Tests ergaben, dass Kaldi die geheimen Botschaften tatsächlich nicht mehr verstand, es sei denn sie wurden in die für Menschen wahrnehmbaren Bereiche verschoben. „Das veränderte die Audiodatei aber merklich", berichtet Thorsten Eisenhofer. „Die Störgeräusche, in denen die geheimen Befehle versteckt sind, wurden deutlich hörbar."

Quelle: Wissenschaftsmagazin Rubin | Klar 7 / 10° C Luftfeuchte: 76% |

| Klar 2 / 2° C Luftfeuchte: 89% |

| Klar 6 / 9° C Luftfeuchte: 76% |